AlexaSteinbrück / AI /可解釋的AI / CC-BY 4.0許可的更好圖像

您會相信人工智能軟件可以為您診斷嗎?大多數人會對這個問題負面回答。確實,儘管AI和神經網絡取得了重大進步,但它們的“黑匣子”性質是我們信任的重大障礙。無法理解模型如何得出的結論或為什麼對其使用的持懷疑態度,尤其是在醫療保健,金融或法律制度等敏感領域。這是可以解釋的AI(XAI)發揮作用的地方,該研究領域著重於解釋AI模型的預測。

我們的論文通過開發可以直接轉化為邏輯的新型神經網絡來為這一領域做出了貢獻。為什麼要邏輯?從很小的時候開始,我們被教導使用邏輯陳述。邏輯構成了人類如何解釋決策,理解複雜問題並向他人傳達推理的主幹。通過將邏輯嵌入神經網絡的結構中,我們旨在以對人們的直觀和值得信賴的方式來解釋其預測。

諸如Logic解釋的以前的作品(Ciravegna等,2023)提出了通過使用真實表以邏輯形式的解釋。儘管這種方法在保留神經網絡的力量和對其預測的解釋之間提供了良好的平衡,但他們的解釋產生是事後完成的。這意味著通過識別輸出和輸入之間的邏輯關係訓練模型後得出解釋。因此,生成的邏輯解釋可能與模型的行為並不完全一致。

在我們的論文中,我們建議通過開發一個稱為透明的可解釋邏輯層的新型神經網絡層來解決這個問題,或者說。該層使我們能夠直接從模型的權重得出規則,從而確保模型的預測和規則之間的對齊。

告訴

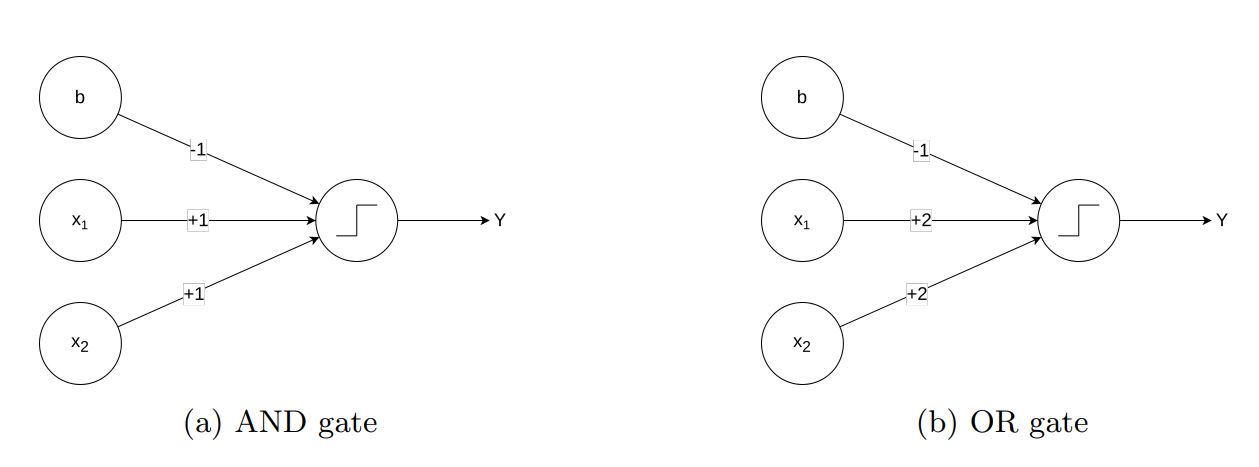

在通常在深度學習類別中顯示的第一個示例中,我們經常發現能夠近似邏輯門的體系結構。正是從這些體系結構中,我們獲得了可以代表邏輯規則的圖層的靈感。例如,如果我們檢查圖1中表示的和和 /或門的門,我們可以觀察到,通過使用Heaviside步驟函數,可以利用偏置來利用偏置到閾值輸入值,從而復制這些門的行為。

圖1:兩個神經網絡體系結構的圖形表示,近似和 /或邏輯門

圖1:兩個神經網絡體系結構的圖形表示,近似和 /或邏輯門

儘管這些體系結構為神經網絡如何模擬邏輯門提供了令人信服的演示,但定義可以學習邏輯規則的體系結構遠非簡單。具體而言,這些示例中使用的Heaviside步驟功能通過梯度下降對訓練提出了重大挑戰。講述背後的直覺在於用Sigmoid函數代替Heaviside功能,這可以近似其行為,同時允許基於梯度的優化。考慮具有Sigmoid激活函數的線性層:

![]() 。

。

我們知道,要產生積極的結果,Sigmoid的論點必須是積極的。這意味著,如果我們能找到所有的權重集,以使參數是積極的,我們可以完全解釋我們的層。但是,隨著功能數量的增加,找到這些組合在計算上變得複雜。為了簡化這一點,我們假設二進制輸入和正權重(同時允許偏見採用任何值)。正式地,此假設可確保該層是“單調的”,這意味著增加任何功能的值都可以保持或增加層的輸出。假設二進制輸入,每個功能都充當一個“開關”,可以打開或關閉特定的重量。通過識別所有產生正總和的輸入組合,我們可以得出該圖層的邏輯規則。

為了清楚起見,讓我們以這個例子 ![]() :

:

![]() 。

。

很容易看到,給定輸入 ![]() ,Sigmoid的論點加起來

,Sigmoid的論點加起來 ![]() ,這是積極的,然後產生積極的結果。相反,考慮輸入

,這是積極的,然後產生積極的結果。相反,考慮輸入 ![]() Sigmoid的論點加起來

Sigmoid的論點加起來 ![]() ,隨著論點總結為負值,這會產生負面結果。

,隨著論點總結為負值,這會產生負面結果。

現在,更清楚的是我們如何從該層中獲得邏輯規則:我們只需要 識別具有相應權重的特徵子集,總計為大於 ![]() 。為此,我們可以從最高的重量開始,然後嘗試所有權重的組合,從而減少順序。例如,對於上面的示例,由此產生的解釋將是:

。為此,我們可以從最高的重量開始,然後嘗試所有權重的組合,從而減少順序。例如,對於上面的示例,由此產生的解釋將是:

![]() 。

。

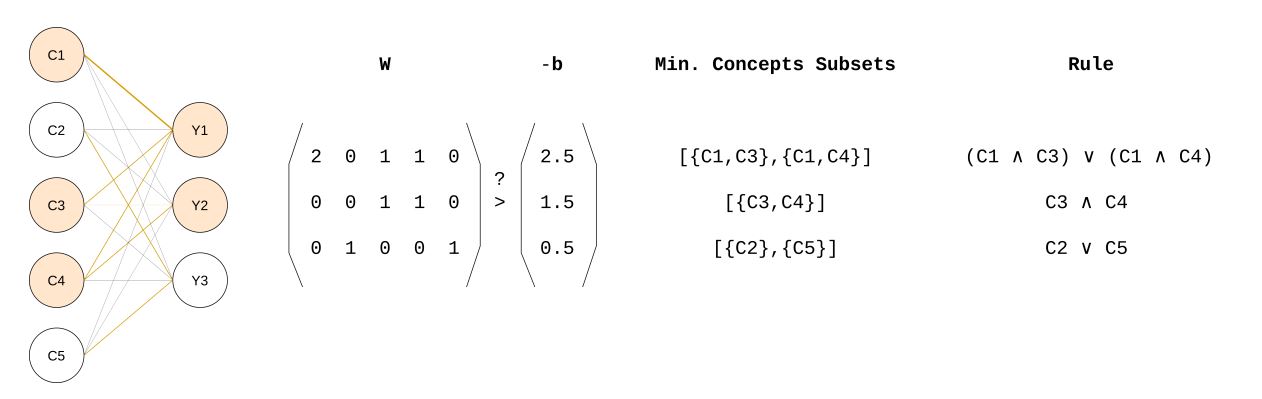

圖2:在多輸出的情況下,講述的結構。對於每個輸出,我們提取權重的子集,總計高於一個大於

圖2:在多輸出的情況下,講述的結構。對於每個輸出,我們提取權重的子集,總計高於一個大於 ![]() ,我們報告相應的邏輯規則。

,我們報告相應的邏輯規則。

圖2提出了在多個輸出的情況下僅解釋的過程的視覺方案。對於空間和閱讀流動性,在這篇文章中,我們沒有介紹該層的數學證明和實現的詳細信息,但是您可以在已發布的文章中找到它們。現在,我們已經定義瞭如何設計一個可讀取的邏輯規則的圖層,在下一節中,我們可以查看算法,該算法使我們能夠從訓練有素的模型中檢索這些規則。規則提取程序

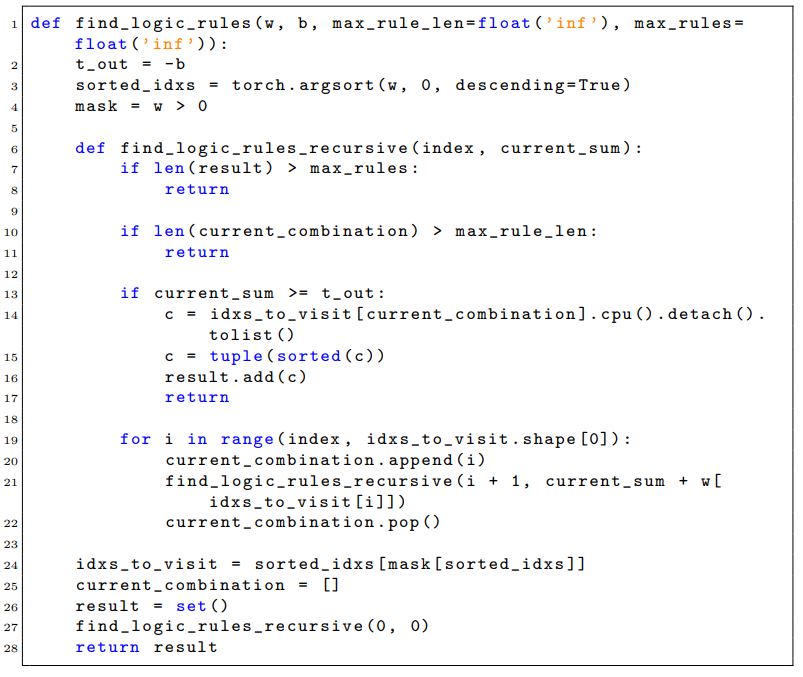

由權重的遞歸函數組成,該函數搜索所有子集的總和高於偏差的負數。天真的方法在所有權重的所有組合中迭代。由於Tell的單調屬性,實際上,我們不必尋找權重的所有組合。實際上,在開始搜索之前,我們按降順序對權重進行分類。這是用於規則提取程序的Python實施:

清單1:python函數查找邏輯規則

清單1:python函數查找邏輯規則

總體而言,Tell提供了一種新穎的方法,可以將邏輯推理直接嵌入神經網絡中,從而確保解釋自然與模型的行為保持一致。這項工作代表了使AI系統更加透明和值得信賴的一步,尤其是對於敏感應用程序。有關更多詳細信息,這裡是讀者可以使用的有用資源的列表:

- 我們的論文:透明的可解釋邏輯層, A. Ragno,M。Plantevit,C。Robardet,R。Capobianco。。 ECAI 2024,iOS出版社,2024年。

- 告訴存儲庫

- 邏輯解釋了網絡, G. Ciravegna,P。Barbiero,F。Giannini,M。Gori,P。Lio,M。Maggini和S. Melacci。。人工智能,2023年。

這項工作是在ECAI 2024年提出的。

標籤:ECAI2024

Alessio Ragno是Insa Lyon的AI顧問和博士後研究員

Alessio Ragno是Insa Lyon的AI顧問和博士後研究員