नवीनतम अपडेट और प्रमुख एआई कवरेज पर विशिष्ट सामग्री के लिए हमारे दैनिक और साप्ताहिक समाचार पत्र में शामिल हों। और अधिक जानें

हांगकांग विश्वविद्यालय और कैलिफोर्निया विश्वविद्यालय, बर्कले, से पता चलता है कि जब उनके स्वयं के समाधान अभी तक बनाए गए हैं, तो भाषा के मॉडल को बेहतर सामान्य किया जा सकता है। निष्कर्ष, जो मॉडल डेलो (एलएलएमएस) और विज़न लैंग्वेज मॉडल (वीएलएम) के दोनों बड़े मॉडल पर लागू होते हैं, एलएलएम समुदाय के मुख्य मान्यताओं में से एक को चुनौती देते हैं-थेड-लेबल प्रशिक्षण उदाहरणों की आवश्यकता होती है। वास्तव में, शोधकर्ताओं से पता चलता है कि कई हाथ से किए गए उदाहरणों पर प्रशिक्षण मॉडल के अदृश्य डेटा को सामान्य करने के लिए मॉडल की क्षमता प्रतिकूल रूप से प्रभावित हो सकती है।

मॉडल प्रशिक्षण में एसएफटी बनाम आरएल

एक लंबे समय के लिए, मनाया गया फाइन-ट्यूनिंग (एसएफटी) प्रशिक्षण एलएलएम और वीएलएम का एक सुनहरा मानक रहा है। एक बार एक मॉडल कच्चे पाठ और छवि डेटा पर पूर्व-संत है, कंपनियां और एआई लैब्स आमतौर पर प्रश्न/उत्तर या अनुरोध/प्रतिक्रिया प्रारूप में हाथ से गठित उदाहरणों के एक बड़े डेटासेट पर पोस्ट-ट्रेन पोस्ट करते हैं। एसएफटी के बाद, मॉडल अतिरिक्त प्रशिक्षण चरणों से गुजर सकता है, जैसे कि मानव प्रतिक्रिया (आरएलएचएफ) से सुदृढीकरण शिक्षा, जहां मॉडल उत्तर संकेतों के आधार पर गर्भवती मानव विकल्पों को सीखने या मॉडल उत्तरों का चयन/नापसंद करने के लिए सीखने की कोशिश करता है।

एसएफटी मॉडल के व्यवहार को इस बात के लिए उपयोगी है कि मॉडल निर्माताओं ने किस तरह के काम किए हैं। हालांकि, डेटा एकत्र करना एक धीमी और महंगी प्रक्रिया है, जो कई कंपनियों और प्रयोगशालाओं के लिए एक बाधा है।

LLMS के हालिया विकास ने शुद्ध सुदृढीकरण शिक्षा (RL) दृष्टिकोणों में रुचि पैदा की है, जहां मॉडल को एक कार्य दिया जाता है और इसे हाथ -हाथ के उदाहरणों के बिना स्वयं सीखना पड़ता है। सबसे महत्वपूर्ण उदाहरण DIPPIC-R1 है, O1 प्रतिद्वंद्वियों को खोलें जो ज्यादातर सुदृढीकरण सीखने के लिए जटिल तर्क कार्यों को सीखने के लिए उपयोग करते हैं।

सामान्यकरण

मशीन लर्निंग (एमएल) सिस्टम की मुख्य समस्याओं में से एक अत्यधिक फिट है, जहां मॉडल अपने प्रशिक्षण डेटा पर अच्छा प्रदर्शन करता है लेकिन अदृश्य उदाहरणों को सामान्य करने में विफल रहता है। प्रशिक्षण के दौरान, मॉडल का काम उनकी गलत छाप देता है, जबकि व्यवहार में वह अपने प्रशिक्षण के उदाहरणों को याद करता है। बड़े और जटिल एआई मॉडल में, सामान्यीकरण को स्मृति से अलग करना मुश्किल हो सकता है।

नया अध्ययन आरएल सामान्यीकरण क्षमताओं और पाठ और दृश्य तर्क कार्यों में एसएफटी प्रशिक्षण पर केंद्रित है। पाठ तर्क के लिए, नियमों के एक सेट पर प्रशिक्षित एलएलएम को उन नियमों के प्रकारों को सामान्य करने में सक्षम होना चाहिए। दृश्य तर्क में, वीएलएम दृश्य इनपुट के विभिन्न पहलुओं, जैसे कि रंग और स्थानिक लेआउट, परिवर्तन के खिलाफ काम के प्रदर्शन में सुसंगत होना चाहिए।

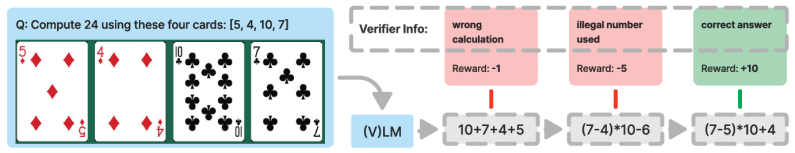

अपने प्रयोगों में, शोधकर्ताओं ने दो प्रतिनिधि कार्यों का उपयोग किया। पहला जनरलपॉइंट था, एक बेंचमार्क जिसने मॉडल की अंकगणितीय तर्क क्षमताओं का मूल्यांकन किया। मॉडल को चार कार्ड दिए जाते हैं, जैसे कि पाठ्य विवरण या चित्र, और उन्हें लक्ष्य संख्या तक पहुंचने के लिए उन्हें संलग्न करने के लिए कहा जाता है। शासित सामान्यीकरण का अध्ययन करने के लिए, शोधकर्ताओं ने नियमों के एक सेट का उपयोग करके मॉडल को प्रशिक्षित किया, फिर एक अलग नियम का उपयोग करके इसका मूल्यांकन किया। दृश्य सामान्यीकरण के लिए, उन्होंने एक रंग कार्ड का उपयोग करके मॉडल को प्रशिक्षित किया और अन्य रंगों और नंबरिंग प्लान कार्ड पर इसके प्रदर्शन का परीक्षण किया।

एक अन्य फ़ंक्शन V-AIR है, जो एक वास्तविक दृश्य इनपुट का उपयोग करता है, ओपन-वर्ल्ड शोधकर्ता डोमेन में मॉडल की स्थानिक तर्क क्षमताओं का परीक्षण करता है। यह फ़ंक्शन शुद्ध भाषा और दृष्टि-भाषा के छंदों में भी आता है। शोधकर्ताओं ने निर्देशों और दृश्य अभ्यावेदन के प्रकार को बदलकर सामान्यीकरण का मूल्यांकन किया कि मॉडल को प्रशिक्षित और परीक्षण किया गया था।

उन्होंने लालमा -.2 -विज़न -11 बी पर अपने परीक्षण खेले, एक छोटे से एसएफटी डेटासेट पर प्रशिक्षण देकर मॉडल को गर्म किया, फिर प्रत्येक कार्य के लिए अलग -अलग संस्करण और प्रशिक्षण पैटर्न के लिए विभिन्न संस्करणों को बनाया। प्रत्येक कार्य के लिए, उन्होंने आरएल और एसएफटी पर अलग से प्रशिक्षण को बढ़ाया। एसएफटी प्रक्रिया अतिरिक्त हाथ से समाधान पर मॉडल को प्रशिक्षित करती है, जबकि आरएल मॉडल को प्रत्येक समस्या के लिए कई समाधानों का उत्पादन करने की अनुमति देता है, परिणामों का मूल्यांकन करता है और सही उत्तरों पर खुद को प्रशिक्षित करता है।

निष्कर्ष बताते हैं कि सुदृढीकरण लगातार उदाहरणों पर प्रदर्शन में सुधार करता है जो शिक्षा प्रशिक्षण डेटा से बहुत अलग हैं। दूसरी ओर, SFT, प्रशिक्षण के नियमों को याद करता है और वितरण (OOD) के उदाहरणों को सामान्य नहीं करता है। ये अवलोकन केवल पाठ-केवल और मल्टीमॉडल सेटिंग्स पर लागू होते हैं।

वास्तविक दुनिया के अनुप्रयोगों के लिए जानकारी

जबकि उनके प्रयोगों से पता चलता है कि आरएल एसएफटी की तुलना में सामान्यीकरण में बेहतर है, शोधकर्ताओं ने यह भी पाया कि एसएफटी मॉडल आउटपुट प्रारूप को स्थिर करने में सहायक है, और आरएल को इसके प्रभाव को प्राप्त करने में सक्षम करना महत्वपूर्ण है। शोधकर्ताओं ने पाया कि, प्रारंभिक एसएफटी चरण के बिना, आरएल प्रशिक्षण ने वांछनीय परिणाम प्राप्त नहीं किए हैं।

यह दीपस्क-आर 1-जीरो द्वारा प्राप्त परिणामों से थोड़ा अलग है, जो शुद्ध आरएल पर पोस्ट-प्राइस था। शोधकर्ताओं का सुझाव है कि यह उनके प्रयोगों में उपयोग किए जाने वाले विभिन्न बैकबोन मॉडल के कारण हो सकता है।

यह स्पष्ट है कि आरएल-ओवरसी दृष्टिकोणों में बहुत गन्दी संभावना है। उपयोग के मामलों के लिए, जिनका परीक्षण किया जा सकता है, मॉडल को अपने दम पर सीखने देना अक्सर अपेक्षित परिणाम हो सकते हैं जो मनुष्य खुद नहीं बना सकते हैं। इन सेटिंग्स का बहुत उपयोग किया जा सकता है जहां हाथ से उदाहरण के उदाहरण उबाऊ और महंगे हो सकते हैं।

वीबी दैनिक के साथ पेशेवर उपयोग के मामलों पर दैनिक अंतर्दृष्टि

यदि आप अपने बॉस को प्रभावित करना चाहते हैं, तो VB ने आपको दैनिक कवर किया है। हम आपको अंदर की स्कूप देते हैं कि विनियामक शिफ्ट से लेकर प्रैक्टिकल परिनियोजन तक की कंपनियां एआई उत्पन्न करने के साथ क्या कर रही हैं, इसलिए आप अधिकतम आरओआई के लिए अंतर्दृष्टि साझा कर सकते हैं।

हमारी गोपनीयता नीति पढ़ें

सदस्यता के लिए धन्यवाद। यहां और अधिक वीबी न्यूज़लेटर्स देखें।

एक त्रुटि पाई गई।