人工智能(AI)的快速發展導致了能夠理解和產生類似人類文本的複雜模型的發展。在現實世界應用程序中部署這些大語言模型(LLM)提出了重大挑戰,尤其是在優化性能和有效管理計算資源方面。

擴展AI推理模型的挑戰

隨著AI模型的複雜性的增長,其部署需求會增加,尤其是在推理階段(模型基於新數據產生輸出的階段)。主要挑戰包括:

- 資源分配: 在廣泛的GPU簇中平衡計算載荷以防止瓶頸和未實現的不足是複雜的。

- 減少延遲: 確保快速響應時間對於用戶滿意度至關重要,需要低延遲推理過程。

- 成本管理: LLMS的實質計算要求可能導致運營成本不斷升級,從而使成本效益的解決方案至關重要。

引入NVIDIA DYNAMO

為了應對這些挑戰,NVIDIA引入了 發電機,一個開源推論庫,旨在有效,成本效益地加速和擴展AI推理模型。作為NVIDIA Triton推理服務器™的後繼產品,Dynamo提供了一個針對分佈式環境量身定制的模塊化框架,從而使大型GPU機隊的推理工作負載無縫縮放。

技術創新和利益

Dynamo結合了幾種關鍵創新,共同提高推理性能:

- 分解服務: 這種方法將LLM推理的上下文(預填充)和生成(解碼)階段分開,將它們分配給不同的GPU。通過允許獨立優化每個階段,分類的服務可以改善資源利用率,並增加每個GPU服務的推理請求數量。

- GPU資源計劃者: Dynamo的計劃引擎可以動態調整GPU分配,以響應用戶需求的波動,防止過度或欠缺並確保最佳性能。

- 智能路由器: 該組成部分有效地指導了大型GPU機隊的傳入推理請求,從而通過利用先前請求的知識(稱為KV緩存)來最大程度地減少昂貴的重新計算。

- 低延遲通信庫(NIXL): NIXL加速了GPU之間的數據傳輸以及各種內存和存儲類型,從而減少了推理響應時間並簡化了數據交換複雜性。

- KV緩存管理器: 通過將較少訪問的推理數據卸載到更具成本效益的內存和存儲設備上,Dynamo可以降低總體推理成本而不會影響用戶體驗。

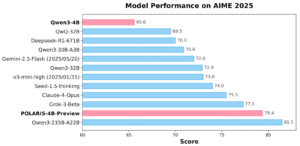

績效見解

Dynamo對推理性能的影響很大。在NVIDIA GB200 NVL72上提供開源DeepSeek-R1 671b推理模型時,Dynamo增加了吞吐量(每秒鐘每秒的令牌),可達30次。此外,在NVIDIA Hopper™上為Llama 70B模型提供服務,導致吞吐量增加了兩倍以上。

這些增強功能使AI服務提供商每GPU提供更多推理請求,加速響應時間並降低運營成本,從而最大程度地提高其加速計算投資的回報。

結論

NVIDIA DYNAMO代表了AI推理模型的部署方面的重大進步,解決了擴展,效率和成本效益方面的關鍵挑戰。它的開源性質和與主要AI推理後端的兼容性,包括Pytorch,Sglang,Nvidia Tensorrt™-LLM和VLLM,Empower Enterprise,Startups and Startups和研究人員,以優化跨不同推論環境的AI模型。通過利用Dynamo的創新功能,組織可以增強其AI功能,提供更快,更有效的AI服務,以滿足現代應用程序不斷增長的需求。

查看 技術細節和GitHub頁面。 這項研究的所有信用都歸該項目的研究人員。另外,請隨時關注我們 嘰嘰喳喳 而且不要忘記加入我們的 80k+ ml子列數。