Достижения в мультимодальных крупных языковых моделях повышают способность ИИ интерпретировать и рассуждать о сложной визуальной и текстовой информации. Несмотря на эти улучшения, поле сталкивается с постоянными проблемами, особенно в задачах математических рассуждений. Традиционные мультимодальные системы ИИ, даже системы с обширными учебными данными и большим количеством параметров, часто пытаются точно интерпретировать и решать математические задачи, включающие визуальные контексты или геометрические конфигурации. Такие ограничения подчеркивают срочную потребность в специализированных моделях, способных анализировать сложные мультимодальные математические проблемы с большей точностью, эффективностью и рассуждениями.

Исследователи в Технологическом университете Nanyang (NTU) представили MMR1-MATH-V0-7B Модель и специализированные MMR1-MATH-RL-DATA-V0 Набор данных решить вышеуказанные критические проблемы. Эта новаторская модель явно адаптирована для математических рассуждений в мультимодальных задачах, демонстрируя заметную эффективность и современную производительность. MMR1-MATH-V0-7B отличается от предыдущих мультимодальных моделей из-за его способности достичь ведущей производительности с использованием удивительно минимального набора учебных данных, что переопределяет контрольные показатели в этом домене.

Модель была точно настроена с использованием только 6000 тщательно кураторских образцов данных из общедоступных наборов данных. Исследователи применили стратегию отбора сбалансированных данных, подчеркивая единообразие с точки зрения сложности проблемы, так и разнообразия математических рассуждений. Систематически отфильтровав чрезмерно упрощенные проблемы, исследователи NTU гарантировали, что набор учебных данных включал проблемы, которые эффективно бросали вызов и расширили возможности рассуждения модели.

Архитектура MMR1-MATH-V0-7B построена на мультимодальной основе QWEN2,5-VL и дополнительно уточняется с использованием нового метода обучения, известного как обобщенная оптимизация политики, управляемой вознаграждением (GRPO). Использование GRPO позволило исследователям эффективно обучать модель в подкреплении обучения в более чем 15 эпох, унося около шести часов на 64 графических процессорах NVIDIA H100. Относительно короткий период обучения и эффективное использование вычислительных ресурсов подчеркивают впечатляющую способность модели для быстрого усвоения и обобщения знаний.

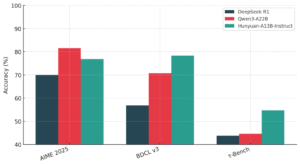

MMR1-MATH-V0-7B был оценен по установленным критериям с использованием стандартизированных VLMevalkit, сосредоточив внимание на мультимодальных задачах математических рассуждений. Критерии включали Mathvista_mini, Mathvision, Logicvista и Mathverse_mini. MMR1-MATH-V0-7B дал новаторские результаты, превосходя существующие модели 7B с открытым исходным кодом и соперничающие даже проприетарные модели со значительно большими параметрами.

В частности, модель достигла точности на 71,0%на Mathvista, превосходя известные аналоги, такие как QWEN2,5-VL (68,2%) и LMM-R1 (63,2%). По Mathvision MMR1-MATH-V0-7B набрал 30,2%, в частности, превзойдя другие выдающиеся модели в том же классе параметров. Кроме того, в Logicvista и Mathverse модель зарегистрированных показателей производительности 50,8% и 45,1% соответственно – более чем ко всем сопоставимым моделям. Эти результаты подчеркивают исключительное обобщение MMR1-MATH-V0-7B и мастерство мультимодальных рассуждений в математических контекстах.

Несколько ключевых выводов из этого релиза включают:

- Модель MMR1-MATH-V0-7B, разработанная исследователями NTU, устанавливает новый современный эталон для мультимодальных математических рассуждений среди моделей параметров с открытым исходным кодом.

- Достигает превосходной производительности, используя исключительно небольшой учебный набор данных всего 6000 тщательно кураторских мультимодальных образцов.

- После 6 часов обучения на 64 NVIDIA H100 графических процессоров, эффективный метод обучения подкреплению (GRPO) работает надежно.

- Дополнительный набор данных MMR1-MATH-RL-DATA-V0, включающий 5780 мультимодальных математических задач, обеспечивает разнообразный, сбалансированный и сложный контент для обучения модели.

- Он превосходит другие выдающиеся мультимодальные модели по стандартным критериям, демонстрируя исключительную эффективность, обобщение и рассуждение в сложных математических сценариях.

Проверить Страница обнимающего лица и страница GitHub. Весь кредит на это исследование направлено на исследователей этого проекта. Кроме того, не стесняйтесь следить за нами Twitter И не забудьте присоединиться к нашему 80K+ ML SubredditПолем

🚨 Познакомьтесь с «Партаном»: разговорная структура ИИ, на первом месте LLM, предназначенную для того, чтобы предоставить разработчикам контроль и точность, которые им нужны, по сравнению с их агентами по обслуживанию клиентов AI, используя поведенческие руководящие принципы и надзор за время выполнения. 🔧 🎛 Он работает с использованием простого в использовании CLI 📟 и нативных SDK клиента в Python и TypeScript 📦.

Сана Хасан, стажер консалтинга в Marktechpost и студент с двойной степенью в IIT Madras, увлечена применением технологий и искусственного интеллекта для решения реальных проблем. С большим интересом к решению практических проблем, он привносит новую перспективу для пересечения ИИ и реальных решений.

Парган: строите надежные агенты, обращенные к клиенту AI с LLMS 💬 ✅ (повышен)