वेब सामग्री और KA RCT से रुझान की निगरानी करना एक बाजार अनुसंधान, सामग्री निर्माण, या आपके क्षेत्र में रहने के लिए बन गया है। इस ट्यूटोरियल में, हम पायथन का उपयोग करके आपके ट्रेंड-फिगरिंग टूल बनाने के लिए एक व्यावहारिक गाइड प्रदान करते हैं। बाहरी एपीआई या जटिल सेटअप की आवश्यकता के बिना, आप सीख सकते हैं कि कैसे सार्वजनिक रूप से सुलभ वेबसाइटों को स्क्रैप करें, शक्तिशाली एनएलपी (प्राकृतिक भाषा प्रसंस्करण) तकनीकों जैसे कि भावुक विश्लेषण और विषय मॉडलिंग को लागू करें, और गतिशील शब्द बादलों का उपयोग करके उभरते रुझानों की कल्पना करें।

import requests

from bs4 import BeautifulSoup

# List of URLs to scrape

urls = ("https://en.wikipedia.org/wiki/Natural_language_processing",

"https://en.wikipedia.org/wiki/Machine_learning")

collected_texts = () # to store text from each page

for url in urls:

response = requests.get(url, headers={"User-Agent": "Mozilla/5.0"})

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extract all paragraph text

paragraphs = (p.get_text() for p in soup.find_all('p'))

page_text = " ".join(paragraphs)

collected_texts.append(page_text.strip())

else:

print(f"Failed to retrieve {url}")ऊपर दिए गए पहले कोड स्निपेट के साथ, हम पायथन के अनुरोधों और ब्यूटीलेसोप का उपयोग करके सार्वजनिक रूप से सुलभ वेबसाइटों से पाठ्य डेटा को स्क्रैप करने का एक सीधा तरीका दिखाते हैं। यह निर्दिष्ट URL से सामग्री प्राप्त करता है, HTML से पैराग्राफ आयत हैं, और संरचित स्ट्रिंग्स को टेक्स्ट डेटा संलग्न करके एनएलपी विश्लेषण के लिए तैयार करता है।

import re

import nltk

nltk.download('stopwords')

from nltk.corpus import stopwords

stop_words = set(stopwords.words('english'))

cleaned_texts = ()

for text in collected_texts:

# Remove non-alphabetical characters and lower the text

text = re.sub(r'(^A-Za-z\s)', ' ', text).lower()

# Remove stopwords

words = (w for w in text.split() if w not in stop_words)

cleaned_texts.append(" ".join(words))उसके बाद, हम स्क्रैप किए गए पाठ को एक लोअरकेस में परिवर्तित करके पाठ को साफ करते हैं, विराम चिह्न और विशेष वर्णों को हटा देते हैं, और एनएलटीके का उपयोग करके साधारण अंग्रेजी स्टॉपवर्ड्स को फ़िल्टर करते हैं। यह प्रीप्रोसेसिंग यह सुनिश्चित करता है कि पाठ डेटा एक स्वच्छ, केंद्रित और सार्थक एनएलपी विश्लेषण के लिए तैयार है।

from collections import Counter

# Combine all texts into one if analyzing overall trends:

all_text = " ".join(cleaned_texts)

word_counts = Counter(all_text.split())

common_words = word_counts.most_common(10) # top 10 frequent words

print("Top 10 keywords:", common_words)अब, हम शीर्ष 10 सबसे अधिक बार कीवर्ड की पहचान करते हुए, हमारे द्वारा साफ किए गए पाठ डेटा से शब्द आवृत्तियों की गणना करते हैं। यह एकत्र किए गए दस्तावेजों में मजबूत रुझानों और आवर्ती विषयों को उजागर करने में मदद करता है, जो स्क्रैप्ड सामग्रियों में लोकप्रिय या महत्वपूर्ण विषयों की तत्काल अंतर्दृष्टि प्रदान करता है।

!pip install textblob

from textblob import TextBlob

for i, text in enumerate(cleaned_texts, 1):

polarity = TextBlob(text).sentiment.polarity

if polarity > 0.1:

sentiment = "Positive 😀"

elif polarity < -0.1:

sentiment = "Negative 🙁"

else:

sentiment = "Neutral 😐"

print(f"Document {i} Sentiment: {sentiment} (polarity={polarity:.2f})")हम एनएलटीके के शीर्ष पर निर्मित एक पायथन लाइब्रेरी, एक पायथन लाइब्रेरी का उपयोग करके प्रत्येक साफ किए गए पाठ दस्तावेज़ पर भावना का विश्लेषण करते हैं। यह प्रत्येक दस्तावेज़ के समग्र भावनात्मक स्वर का मूल्यांकन करता है - सकारात्मक, नकारात्मक या तटस्थ - और एक संख्यात्मक ध्रुवीयता स्कोर के साथ आत्मा को प्रिंट करता है, जो पाठ डेटा में एक सामान्य मनोदशा या दृष्टिकोण का त्वरित संकेत देता है।

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.decomposition import LatentDirichletAllocation

# Adjust these parameters

vectorizer = CountVectorizer(max_df=1.0, min_df=1, stop_words="english")

doc_term_matrix = vectorizer.fit_transform(cleaned_texts)

# Fit LDA to find topics (for instance, 3 topics)

lda = LatentDirichletAllocation(n_components=3, random_state=42)

lda.fit(doc_term_matrix)

feature_names = vectorizer.get_feature_names_out()

for idx, topic in enumerate(lda.components_):

print(f"Topic {idx + 1}: ", (vectorizer.get_feature_names_out()(i) for i in topic.argsort()(:-11:-1)))उसके बाद, हम नवीनतम डायरिकलेट आवंटन (LDA) लागू करते हैं - पाठ कॉर्पस में अंतर्निहित विषयों को खोजने के लिए एक लोकप्रिय विषय मॉडलिंग एल्गोरिथ्म। इसने पहले एक सीक्वल-लर्न काउंटरवेक्टर का उपयोग करके संख्यात्मक दस्तावेज़-टर्म मैट्रिक्स को साफ किया, फिर प्राथमिक विषयों की पहचान करने के लिए एलडीए मॉडल को फिट किया। आउटपुट प्रत्येक खोजे गए विषय के लिए शीर्ष कीवर्ड को सूचीबद्ध करता है, संक्षेप में एकत्र किए गए डेटा में प्रमुख अवधारणाओं को संक्षेप में प्रस्तुत करता है।

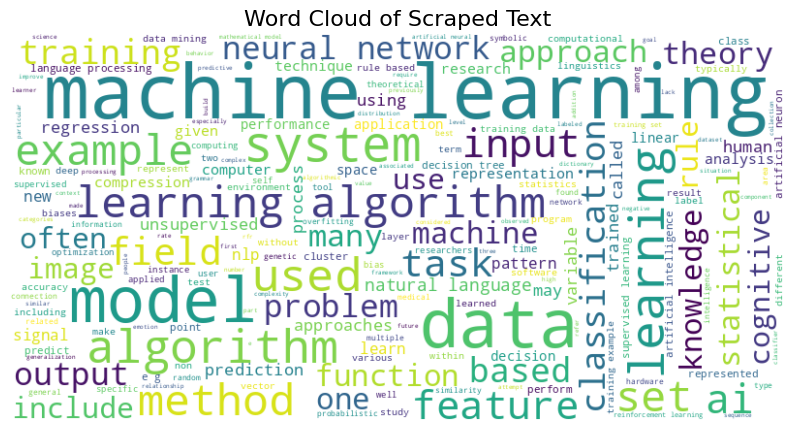

# Assuming you have your text data stored in combined_text

from wordcloud import WordCloud

import matplotlib.pyplot as plt

import nltk

from nltk.corpus import stopwords

import re

nltk.download('stopwords')

stop_words = set(stopwords.words('english'))

# Preprocess and clean the text:

cleaned_texts = ()

for text in collected_texts:

text = re.sub(r'(^A-Za-z\s)', ' ', text).lower()

words = (w for w in text.split() if w not in stop_words)

cleaned_texts.append(" ".join(words))

# Generate combined text

combined_text = " ".join(cleaned_texts)

# Generate the word cloud

wordcloud = WordCloud(width=800, height=400, background_color="white", colormap='viridis').generate(combined_text)

# Display the word cloud

plt.figure(figsize=(10, 6)) # <-- corrected numeric dimensions

plt.imshow(wordcloud, interpolation='bilinear')

plt.axis('off')

plt.title("Word Cloud of Scraped Text", fontsize=16)

plt.show()

अंत में, हम एक शब्द क्लाउड विज़ुअलाइज़ेशन का उत्पादन करते हैं, जो समग्र और स्वच्छ पाठ डेटा से अग्रणी कीवर्ड प्रदर्शित करता है। नेत्रहीन लगातार और प्रासंगिक स्थितियों से, यह दृष्टिकोण एकत्र की गई वेब सामग्री में प्रमुख रुझानों और विषयों के सहज अनुसंधान के लिए अनुमति देता है।

एक स्क्रैप साइट से क्लाउड आउटपुट वर्ड

अंत में, हमने सफलतापूर्वक एक मजबूत और इंटरैक्टिव ट्रेंड-फिगरिंग टूल बनाया है। यह अभ्यास वेब स्क्रैपिंग, एनएलपी विश्लेषण, विषय मॉडलिंग और शब्द बादलों का उपयोग करके सहज ज्ञान युक्त दृश्य के अनुभव से सुसज्जित है। इस शक्तिशाली अभी तक प्रत्यक्ष दृष्टिकोण के साथ, आप लगातार उद्योग के रुझानों का पता लगा सकते हैं, सामाजिक और ब्लॉग सामग्री से मूल्यवान अंतर्दृष्टि प्राप्त कर सकते हैं, और वास्तविक समय के डेटा के आधार पर सूचित निर्णय ले सकते हैं।

यहाँ है कोटिनी नोटबुक। इसके अलावा, हमें फॉलो करना न भूलें ट्विटर और हमसे जुड़ें टेलीग्राफिक मीडिया और लिंक्डइन जी.आर.सिर हिलाकर सहमति देना। हमसे जुड़ने के लिए मत भूलना 80K+ एमएल सबमिटेड।

। MEET PALLANT: व्यवहार दिशानिर्देशों और रनटाइम मॉनिटरिंग का उपयोग करके, अपने AI ग्राहक सेवा एजेंटों पर आवश्यक नियंत्रण और सटीकता प्रदान करने के लिए AI फ्रेमवर्क डेवलपर्स को प्रदान करने के लिए एक LLM-FIRST वार्तालाप किया गया है। 🔧 🔧 🎛 इसका उपयोग करना आसान है। और पायथन और टाइपस्क्रिप्ट में मूल ग्राहक एसडीके का उपयोग करके संचालित है।

ASIF Razzaq एक दूरदर्शी उद्यमी और इंजीनियर के रूप में मार्केटएकपोस्ट मीडिया इंक के सीईओ हैं, ASIF सामाजिक अच्छे के लिए कृत्रिम बुद्धिमत्ता की संभावना को बढ़ाने के लिए प्रतिबद्ध है। उनका सबसे हालिया प्रयास आर्टिफिशियल इंटेलिजेंस मीडिया प्लेटफॉर्म, मार्कटेकपोस्ट का उद्घाटन है, जो मशीन लर्निंग की गहराई के लिए और कवरेज की गहराई के लिए गहरी सीखने की खबर के लिए है। यह तकनीकी रूप से ध्वनि है और एक बड़े दर्शकों द्वारा आसानी से समझ में आता है। प्लेटफ़ॉर्म में 2 मिलियन से अधिक मासिक दृश्य हैं, जो दर्शकों के बीच अपनी लोकप्रियता दिखाते हैं।

पार्लेंट: LLMS (B ED) के साथ एक विश्वसनीय AI ग्राहक का सामना करना