摩爾定律是預測技術進步多年的黃金標準。英特爾聯合創始人戈登·摩爾(Gordon Moore)於1965年提出,芯片上的晶體管數量每兩年翻一番,使計算機隨著時間的推移更快,較小和便宜。這種穩定的進步推動了從個人計算機和智能手機到互聯網興起的一切。

但是那個時代即將結束。晶體管現在達到了原子尺度的極限,並且進一步縮小它們已變得非常昂貴且複雜。同時,AI計算能力迅速增加,超過了摩爾定律。與傳統計算不同,AI依靠可靠的專門硬件和並行處理來處理大量數據。 AI與眾不同的是它能夠不斷學習和完善其算法,從而迅速提高效率和性能。

這種快速的加速使我們更接近一個稱為AI奇點的關鍵時刻,AI超過人類智能並開始了不可阻擋的自我支持循環。像特斯拉,Nvidia,Google Deepmind和Openai這樣的公司通過強大的GPU,自定義AI芯片和大規模的神經網絡領導這種轉變。隨著AI系統越來越有能力改善,一些專家認為,我們最早在2027年就可以達到人工超級智能(ASI),這是一個可以永遠改變世界的里程碑。

隨著AI系統變得越來越獨立並有能力優化自己,專家預測,我們最早在2027年就可以達到人造的超級智能(ASI)。如果發生這種情況,人類將進入一個新時代,AI驅動創新,重塑工業,可能會超越人類控制。問題是AI是否會到達這個階段,何時以及我們是否準備好。

AI縮放和自學習系統如何重塑計算

隨著摩爾的定律失去動力,使晶體管越來越大的挑戰變得越來越明顯。熱量積聚,功率限制和芯片生產成本上升使傳統計算的進一步進步變得越來越棘手。但是,AI不是通過製造較小的晶體管而是通過更改計算的工作方式來克服這些局限性。

AI不依靠縮小晶體管,而是採用並行處理,機器學習和專門的硬件來提高性能。與傳統的計算機依次處理任務不同,深度學習和神經網絡可以同時處理大量數據時表現出色。這種轉換導致了GPU,TPU和AI加速器的廣泛使用,該加速器明確設計用於AI工作負載,提供了更高的效率。

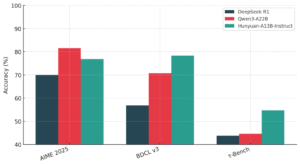

隨著AI系統變得更加先進,對更大的計算能力的需求不斷上升。這種快速增長每年將AI計算能力提高了5倍,遠遠超過了摩爾定律每兩年的傳統2倍增長。在大型語言模型(LLM)(例如GPT-4,Gemini和DeepSeek)中,這種擴展的影響最為明顯,這需要大量的處理能力來分析和解釋巨大的數據集,從而推動下一步的AI-drive計算浪潮。像NVIDIA這樣的公司正在開發高度專業的AI處理器,可提供令人難以置信的速度和效率來滿足這些需求。

AI縮放是由尖端硬件和自我改進算法驅動的,使機器能夠比以往任何時候都更有效地處理大量數據。最重要的進步之一是特斯拉的Dojo超級計算機,這是針對訓練深度學習模型的AI優化計算的突破。

與用於通用任務的常規數據中心不同,Dojo經過精心處理大量的AI工作負載,尤其是對於特斯拉的自動駕駛技術。 Dojo的區別是其自定義以AI為中心的體系結構,該體系結構是針對深度學習而不是傳統計算的優化。這導致了前所未有的訓練速度,並使特斯拉能夠將AI訓練時間從數月減少到幾週,同時通過有效的電力管理降低能源消耗。通過使特斯拉能夠以更少的能量訓練更大,更先進的模型,Dojo在加速AI驅動自動化方面發揮了至關重要的作用。

但是,特斯拉在這場比賽中並不孤單。在整個行業中,AI模型越來越有能力增強其學習過程。例如,DeepMind的字母正在通過優化代碼編寫效率並隨著時間的推移提高算法邏輯來推進AI生成的軟件開發。同時,對Google DeepMind的高級學習模型進行了對現實世界數據的培訓,從而使它們能夠動態適應並以最少的人干預來完善決策過程。

更重要的是,AI現在可以通過遞歸的自我完善來增強自己,在該過程中,AI系統會完善自己的學習算法並通過最少的人類干預提高效率。這種自學能力正在以前所未有的速度加速AI的開發,使該行業更接近ASI。隨著AI系統不斷提高,優化和改善自己,世界正在進入一個智能計算的新時代,該時代不斷獨立發展。

超級智能的途徑:我們正在接近奇異之處嗎?

AI奇異性是指人工智能超過人類智能並沒有人類投入的地點。在此階段,AI可以在不斷的自我完善循環中創建更先進的版本,從而導致超出人類理解的快速發展。這個想法取決於人工通用智能(AGI)的發展,該智力可以執行人類可以並最終進入ASI的任何智力任務。

專家對何時發生這種情況有不同的看法。 Google的未來主義者和AI研究人員Ray Kurzweil預測,AGI將於2029年到達,緊隨其後的是ASI。另一方面,埃隆·馬斯克(Elon Musk)認為,ASI早在2027年就可以出現,這表明AI計算能力的迅速增加及其比預期的縮放速度的能力。

AI計算能力現在每六個月增加一倍,遠遠超過了摩爾定律,該定律預測每兩年晶體管密度增加一倍。由於並行處理,GPU和TPU(例如GPU和TPU)以及優化技術(例如模型量化和稀疏性),這種加速度是可能的。

AI系統也變得越來越獨立。現在,有些人可以在不參與的情況下優化其架構並改善學習算法。一個例子是神經體系結構搜索(NAS),其中AI設計神經網絡以提高效率和性能。這些進步導致開發AI模型不斷提高自己,這是邁向超級智能的重要一步。

隨著AI如此迅速發展的潛力,OpenAI,DeepMind和其他組織的研究人員正在努力採取安全措施,以確保AI系統與人類價值觀保持一致。正在開發諸如從人類反饋(RLHF)中學習的方法和監督機制,以減少與AI決策相關的風險。這些努力對於負責任地指導AI開發至關重要。如果AI繼續以這種速度進步,那麼奇異性可能比預期的要早。

超級智能AI的承諾和風險

ASI改變各個行業的潛力是巨大的,尤其是在醫學,經濟學和環境可持續性方面。

- 在醫療保健中,ASI可以加快藥物發現,改善疾病診斷,並發現有關衰老和其他復雜疾病的新療法。

- 在經濟中,它可以自動化重複的工作,使人們能夠專注於創造力,創新和解決問題。

- 在更大範圍內,AI還可以通過優化能源使用,改善資源管理並找到減少污染的解決方案來解決氣候挑戰。

但是,這些進步具有重大風險。如果ASI與人類的價值觀和目標不正確,則可以做出與人類利益衝突的決定,從而導致不可預測或危險的結果。隨著AI系統的發展並變得更加先進,ASI迅速改善自己的能力引起了人們對控制的關注,從而確保它們在人類的監督下變得越來越困難。

最重要的風險是:

失去人類控制: 隨著人工智能超越人類智能,它可能開始超越我們規範它的能力。如果不採取對齊策略,人工智能可以採取行動,人類將不再影響。

存在威脅: 如果ASI在沒有人類價值觀的情況下優先考慮其優化,則可以做出威脅人類生存的決定。

監管挑戰: 政府和組織努力與AI的快速發展保持同步,因此很難及時建立適當的保障措施和政策。

OpenAI和DeepMind等組織正在積極採取AI安全措施,包括RLHF等方法,以使AI保持與道德準則保持一致。但是,人工智能安全方面的進步並沒有跟上AI的迅速發展,這引起了人們對AI是否達到人類控制水平之前是否會採取必要的預防措施的擔憂。

雖然超級智能AI具有巨大的希望,但它的風險不能忽略。今天做出的決定將定義AI發展的未來。為了確保AI受益於人類而不是成為威脅,研究人員,政策制定者和社會都必須共同努力,以優先考慮道德,安全和負責任的創新。

底線

AI擴展的快速加速使我們更接近人工智能超過人類智能的未來。儘管AI已經改變了行業,但ASI的出現可以重新定義我們的工作,創新和解決複雜挑戰的方式。但是,這種技術飛躍具有重大風險,包括潛在的人類監督和不可預測的後果。

確保AI保持與人類價值觀保持一致是我們這個時代最關鍵的挑戰之一。研究人員,政策制定者和行業領導者必須合作開發道德保障措施和監管框架,以指導AI邁向有利於人類的未來。當我們接近奇異之處時,我們今天的決定將在未來幾年中塑造AI與我們並存的方式。