Обучение больших языковых моделей (LLMS) стало центральным в продвижении искусственного интеллекта, но это не без проблем. По мере того, как размеры модели и наборы данных продолжают расти, традиционные методы оптимизации – в частности, ADAMW – могут показать свои ограничения. Одной из основных трудностей является управление вычислительными затратами и обеспечение стабильности в расширенных тренировочных пробегах. Такие проблемы, как исчезающие или взрывающиеся градиенты, противоречивые величины обновлений по различным матрицам параметров, а также тяжелые потребности в распределенных средах, усложняют процесс. По сути, поскольку исследователи стремятся к моделям с миллиардами параметров и триллионов токенов, существует насущная потребность в более изысканных методах оптимизации, которые могут обрабатывать эти сложности с большей эффективностью и стабильностью.

В попытке решить эти проблемы, AI Moonshot AI в сотрудничестве с UCLA разработал лунный свет-модель смеси эксперт (MOE), оптимизированную с использованием Muon Optimizer. Moonlight предлагается в двух конфигурациях: версия с 3 миллиардами активированных параметров и в общей сложности 16 миллиардов параметров, обученных 5,7 триллиона токена. Эта работа основана на Muon Optimizer, первоначально разработанной для более мелких моделей, масштабируя свои принципы для удовлетворения требований более крупных режимов обучения. Основное инновация Muon заключается в использовании матричной ортогонализации через итерации Ньютона-Шульца. Этот метод помогает гарантировать, что обновления градиента применяются более равномерно для пространства параметров модели. Управляя общими ловушками, связанными с ADAMW, Muon предоставляет многообещающую альтернативу, которая повышает как эффективность обучения, так и стабильность.

Технические детали

Более внимательный взгляд на технические инновации, лежащие в основе Moonlight, показывают вдумчивые коррективы, внесенные в Muon Optimizer. Две основные модификации были ключом к тому, чтобы сделать MUON подходящим для крупномасштабного обучения. Во -первых, интеграция распада веса – техника, обычно используемой с ADAMW, – помогает контролировать рост величин веса, особенно при тренировке с большими моделями и обширным количеством токенов. Без затухания веса веса и выходы слоев могут расти чрезмерно, потенциально снижая производительность модели с течением времени.

Вторая корректировка включает в себя калибровку шкалы обновления на параметры. На практике величина обновления в мюоне может варьироваться в зависимости от формы матриц веса. Чтобы гармонизировать эти обновления, метод масштабирует их в каким -то образом, пропорционально квадратному корню из наибольшего размера каждой матрицы. Это изменение более тесно соответствует поведению MUOON с хорошо понятым исполнением ADAMW и гарантирует, что все параметры обновляются последовательно.

Кроме того, распределенная реализация MUON Builds на методах от Zero-1, разделения состояний оптимизатора между данными, параллельными группами. Этот подход уменьшает накладные расходы на память и ограничивает затраты на связь, обычно связанную с распределенным обучением. Хотя дополнительные шаги, такие как градиенты сбора и выполнение итераций Ньютона-Шульца, требуются, они были оптимизированы, чтобы их влияние на общее время обучения оставалось минимальным. Результатом является оптимизатор, который поддерживает конкурентную производительность, требуя меньшего количества вычислительных ресурсов.

Понимание эмпирических результатов и анализа данных

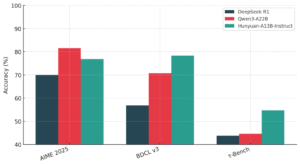

Эмпирические оценки лунного света подчеркивают практические преимущества этих технических улучшений. На промежуточной контрольной точке 1,2 триллиона токенов Moonlight продемонстрировал скромные улучшения по сравнению с аналогом, обученным ADAMW (называемым Moonlight-A) и другими подобными моделями MOE. Например, в задачах, оценивающих понимание языка, лунный свет достиг немного более высоких результатов по критериям, таким как MMLU. В задачах генерации кода его повышение производительности было еще более очевидным, что позволяет предположить, что изысканная механика обновления MUON способствует лучшей общей производительности задач.

Масштабирование юридических экспериментов дополнительно иллюстрирует преимущества MUOON. Эти эксперименты показывают, что MUON может соответствовать производительности моделей, обученных ADAMW, используя только около половины учебных вычислительных затрат. Эта эффективность является важным соображением для исследователей, балансирующих ограничения ресурсов с желанием продвигать модельные возможности. Кроме того, спектральный анализ матриц веса указывает на то, что обучение Moonlight с MUON приводит к более разнообразному диапазону единственных значений. Такое разнообразие в направлениях обновления может помочь модели лучше обобщать по различным задачам.

Дополнительные исследования во время контролируемой фазы тонкой настройки показывают, что, когда предварительно подготовка и тонкая настройка проводятся с помощью MUON, преимущества этого оптимизатора сохраняются на протяжении всего тренировочного трубопровода. В тех случаях, когда оптимизатор переключается между предварительной подготовкой и тонкой настройкой, различия менее выражены, что позволяет предположить, что согласованность в методе оптимизации полезна.

Заключение

Таким образом, разработка лунного света представляет собой вдумчивое развитие в обучении крупных языковых моделей. Приняв Muon Optimizer, команда в Moonshot AI и UCLA предоставила жизнеспособную альтернативу традиционным методам, таким как ADAMW, демонстрируя улучшения в эффективности обучения и стабильности модели. Усовершенствования ключей включают интеграцию распада веса и корректировки в шкалу обновления для параметра, оба из которых помогают гармонизировать обновления по различным типам матриц веса. Распределенная реализация еще больше подчеркивает практические преимущества этого подхода, особенно в снижении накладных расходов на память и общения в крупномасштабных тренировочных средах.

В техническом отчете четко сформулировано понимание, полученное в результате проекта Moonlight, «Muon Musemable для обучения LLM». Эта работа показывает, что в расчетных условиях MUOON может достичь сопоставимой или даже превосходной производительности с ADAMW, значительно снижая вычислительные затраты. В отчете также подчеркивается, что переход от ADAMW на MUON не требует обширной настройки гиперпараметрических данных, упрощая процесс интеграции для исследователей.

Заглядывая в будущее, ожидается, что открытый источник реализации MUON вместе с предварительно проведенными моделями и промежуточными контрольно-пропускными пунктами способствует дальнейшему исследованию масштабируемых методов оптимизации. Будущая работа может изучить продление MUON на другие ограничения нормы или интегрировать его преимущества в единую структуру оптимизации, которая охватывает все параметры модели. Такие усилия могут привести к еще более надежным и эффективным стратегиям обучения, постепенно формируя новый стандарт для разработки LLM.

Проверить Бумага, модель на странице обнимающегося лица и на странице GitHub. Весь кредит на это исследование направлено на исследователей этого проекта. Кроме того, не стесняйтесь следить за нами Twitter И не забудьте присоединиться к нашему 75K+ ML SubredditПолем

🚨 Рекомендуемое чтение AI Research выпускает Nexus: расширенная система интеграции системы ИИ и стандартов соответствия данными для решения юридических проблем в наборах данных AI

ASIF Razzaq является генеральным директором Marktechpost Media Inc. как дальновидного предпринимателя и инженера, ASIF стремится использовать потенциал искусственного интеллекта для социального блага. Его последнее усилие-запуск медиа-платформы искусственного интеллекта, Marktechpost, которая выделяется благодаря глубокому освещению машинного обучения и новостей о глубоком обучении, которое является технически обоснованным и легко понятным для широкой аудитории. Платформа может похвастаться более чем 2 миллионами ежемесячных просмотров, иллюстрируя свою популярность среди зрителей.