बड़े भाषा मॉडल डेलो (एलएलएमएस) ने स्केलिंग और विशेष प्रशिक्षण दृष्टिकोणों में नवीनतम प्रगति के माध्यम से जटिल तर्क कार्यों में असाधारण क्षमताओं को दिखाया है। जबकि Openai O1 और Dippic R1 जैसे मॉडल ने तर्क समस्याओं के उन्मूलन में नए बेंचमार्क सेट किए हैं, विभिन्न भाषाओं में उनके प्रभाव में महत्वपूर्ण असमानताएं मौजूद हैं। लालमा और क्वैन जैसे फाउंडेशन मॉडल के लिए प्रशिक्षण डेटा ने अंग्रेजी और चीनी, कम संसाधन भाषाओं के प्रभुत्व के लिए महत्वपूर्ण क्षमता दूरी बनाई है। हालांकि, इन मॉडलों को झूठे चरित्र की खपत और कोड-स्विचिंग जैसी चुनौतियों का सामना करना पड़ता है। इन मुद्दों को तर्क-केंद्रित फाइन-ट्यूनिंग और सुदृढीकरण सीखने की प्रक्रियाओं के दौरान उच्चारण किया जाता है।

क्षेत्रीय एलएलएम पहल विशेष प्रीट्रेनिंग और बाद के दृष्टिकोणों के माध्यम से कम संसाधन भाषा की सीमाओं पर विचार करने के लिए उभरी है। टाइफून, नाविक, यूरोलम, एया, सी-लायन और सीलम जैसी परियोजनाएं विशिष्ट लक्ष्य भाषाओं के लिए मॉडल स्वीकार करने पर ध्यान केंद्रित करती हैं। हालांकि, तर्क क्षमता के अनुकूल होने के लिए डेटा-फेड दृष्टिकोण में तर्क मॉडल डेटा व्यंजनों में पारदर्शिता का अभाव है। इसके अलावा, स्केलिंग के लिए महत्वपूर्ण गणना संसाधनों की आवश्यकता होती है, जैसे कि R1 70B को परेशान करना और सामान्य SFT के लिए 800k उदाहरणों की आवश्यकता होती है, जो SKY-T1 और BESPOCK-STRATOSE जैसे शैक्षिक प्रयासों से अधिक है। मॉडल विलय एक वैकल्पिक दृष्टिकोण के रूप में उभरा है, जो अतिरिक्त प्रशिक्षण के बिना कार्यों के प्रदर्शन को बेहतर बनाने के लिए कई विशेष मॉडल के वजन के संयोजन का वादा दिखाता है।

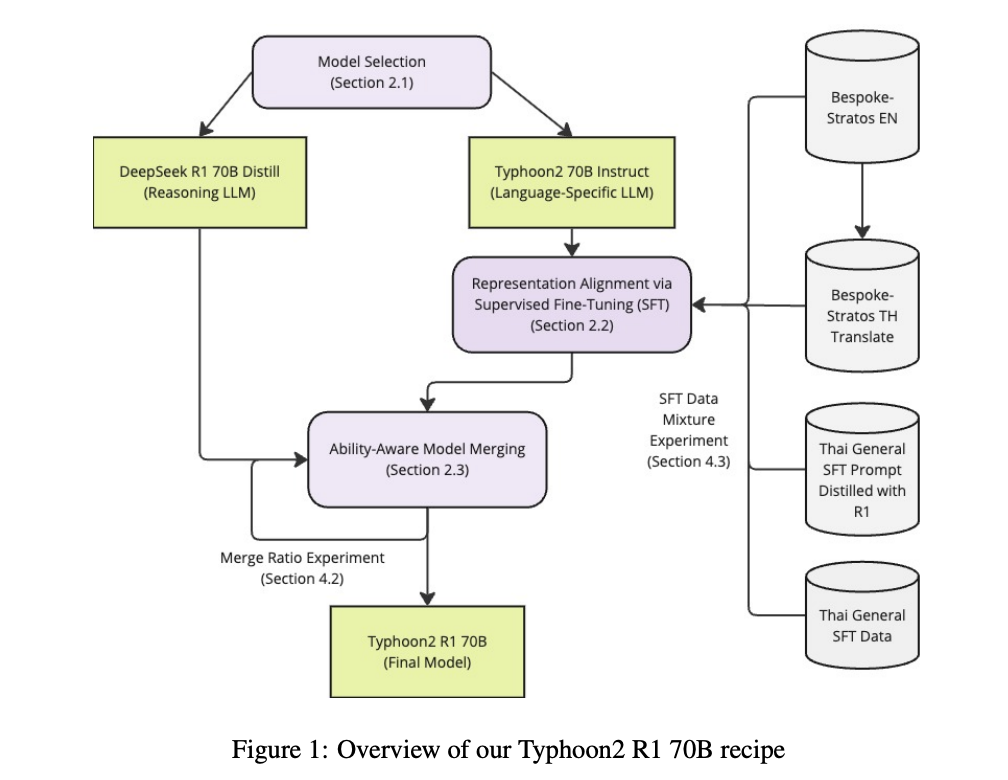

SCB 10x R & D और SCBX समूह बैंकॉक, थाईलैंड में शोधकर्ताओं ने भाषा-विशिष्ट LLM में तर्क को बढ़ाने के लिए एक अभिनव दृष्टिकोण का सुझाव दिया है, विशेष रूप से थाई भाषा मॉडल पर। लक्षित भाषा महारत को बनाए रखते हुए Dippic R1 के समान उन्नत तर्क क्षमताओं को समायोजित करने के लिए अनुसंधान डेटा चयन और मॉडल मर्ज को जोड़ती है। लक्ष्य भाषा के कार्यों पर प्रदर्शित किए बिना, DIPPIC R1 की तर्क क्षमताओं का मिलान करते हुए, केवल कम संसाधन भाषा मॉडल में तर्क क्षमताओं में सुधार की महत्वपूर्ण चुनौती, सार्वजनिक रूप से उपलब्ध डेटासेट का उपयोग करके और $ 1,201 का मामूली गणना बजट।

कार्यान्वित विधि टाइफून 2 70 बी निर्देश और डीपसीक आर 1 70 बी डिस्टिल बेस मॉडल के रूप में उपयोग करते हैं। दृष्टिकोण में टायफून 2 70 बी में देखे गए फाइन-ट्यूनिंग (एसएफटी) को लागू करना और इसे डीआईपीसीआईसी आर 1 70 बी के साथ विलय करना शामिल है। प्रशिक्षण कॉन्फ़िगरेशन विशिष्ट मापदंडों के साथ लोरा को नियुक्त करता है: 32 और 16 के रैंक। सिस्टम 16,384 की अधिकतम लंबाई के साथ अनुक्रम पैकिंग का उपयोग करता है, सिस्टम लिगर कर्नल, फ्लैशर कर्नेल, फ्लैशर -2 और डिप्पीड ज़ीरो -3 के साथ, ज़ी पीटी तक। प्रशिक्षण 4 × एच 100 जीपीयू पर चलता है, जो एक्सोलोटल 4 का उपयोग करके 15 घंटे तक के लिए होता है, मॉडल को विलय द्वारा विलय कर दिया जाता है। मूल्यांकन दो मुख्य पहलुओं पर केंद्रित है: तर्क क्षमता और भाषा कार्य प्रदर्शन, एआईएम 2024, गणित TH-500 और मूल्यांकन के लिए थाई अनुवाद के साथ लाइव रोडबेंच जैसे बेंचमार्क का उपयोग।

प्रायोगिक परिणामों से पता चलता है कि डीईपीसीआईसी आर 1 70 बी एईएम और मैथ 500 जैसे लॉजिक कार्यों में सबसे अच्छा है, लेकिन थाई-विशिष्ट कार्यों जैसे कि एमटीबींच-टू और भाषा सटीकता मूल्यांकन में प्रभावशीलता दिखाता है। टाइफून 2 70 बी अधिसूचना भाषा-विशिष्ट कार्यों में मजबूत प्रदर्शन दिखाती है, लेकिन तर्क चुनौतियों के साथ संघर्ष करती है, एआईएमई में केवल 10% सटीकता प्राप्त करती है, और गणित वें 500 में Dippic R1 को 20% से अधिक पीछे रखता है। अंतिम मॉडल, तुलनात्मक तर्क क्षमताओं को बनाए रखते हुए टाइफून 2 के 4% के भीतर संचालन प्राप्त करते हुए, टाइफून 2-R1-70B, टाइफून 2 की महारत के साथ Dippic R1 की तर्क क्षमताओं को जोड़ती है। यह Dippec R1 की तुलना में टाइफून 2 और 12.8% पर 41.6% के संचालन में सुधार करता है।

अंत में, शोधकर्ता विशिष्ट मॉडल के संयोजन के माध्यम से भाषा-विशिष्ट मॉडल में तर्क क्षमता को बढ़ाने के लिए एक दृष्टिकोण निर्धारित करते हैं। जबकि अध्ययन से साबित होता है कि एसएफटी और मॉडल विलय प्रभावी रूप से सीमित संसाधनों के साथ तर्क क्षमताओं को स्थानांतरित कर सकते हैं, वर्तमान विधि में कई सीमाएं मौजूद हैं। तुलु 3 जैसे उच्च-गुणवत्ता वाले डेटासेट के बावजूद, रिसर्च स्कोप एक एकल मॉडल परिवार में दो-मॉडल सेटअप में साहस को मर्ज करने के लिए सीमित था, बिना izing ट्यूनिंग के। बहुभाषी तर्क और मॉडल मर्ज में महत्वपूर्ण चुनौतियां जारी हैं, जिसमें सांस्कृतिक रूप से जागृत तर्क के निशान की कमी शामिल है। इन चुनौतियों के बावजूद, अनुसंधान एलएलएम क्षमताओं को कम भाषाओं में अग्रणी करने की दिशा में एक कदम दिखाता है।

जाँच करना कागज़। इस शोध के लिए सभी श्रेय इस परियोजना के शोधकर्ताओं को जाते हैं। इसके अलावा, हमें फॉलो करने के लिए स्वतंत्र महसूस करें ट्विटर और हमसे जुड़ने के लिए मत भूलना 75 k+ ml सबमिटेड।

। अनुशंसित ओपन-सीरस एआई प्लेटफॉर्म: ‘इंटेलिजेंट एक ओपन सोर्स मल्टी-एजेंट फ्रेमवर्क है जो जटिल वार्तालाप एआई सिस्टम का मूल्यांकन करता है” (बिस्तर)

साजद अंसारी आईआईटी खड़गपुर से अंतिम वर्ष की स्नातक हैं। एक तकनीकी उत्साही के रूप में, यह एआई तकनीकों और उनके वास्तविक दुनिया के प्रभावों के प्रभाव पर ध्यान केंद्रित करके एआई के व्यावहारिक अनुप्रयोगों पर विचार करता है। इसका उद्देश्य स्पष्ट रूप से और सुलभ जटिल एआई अवधारणाओं का है।

🚨 अनुशंसित ओपन-सीरस एआई प्लेटफॉर्म: ‘इंटेलिजेंट एक ओपन सोर्स मल्टी-एजेंट फ्रेमवर्क है जो कॉम्प्लेक्स वार्तालाप एआई सिस्टम का मूल्यांकन करता है’ (ईडी)